技术SEO就像是你网站的“隐形英雄”,它的作用不可小觑。

想象一下,你的网站里藏着些小毛病,就像隐形的小虫子,你迫不及待想找出来解决掉。但这些问题到底藏在哪里?哪些问题是头号大敌?开始的第一步应该是什么呢?

不要害怕,这不来了嘛!

这个指南是给那些已经对SEO有点儿概念,但还需要进一步搞明白重点的SEO新手和网站负责人们。

当你要对网站做个SEO大检查,或者计划接下来半年的策略时,你可能要检查好几百项内容。

但有些关键问题,如果不处理,可能会让你的网站大受其害。我这里列出了几个特别重要的点。

选择这些点,是因为它们对你网站的健康大有裨益,而且查找起来也挺快的。至于修复这些问题,那就得看你的网站大小和问题的严重程度了。

这个指南并不能解决你所有的问题,它只是个开始。

话不多说,先来个检查清单,把这些项目先搞定,再继续处理网站的其他部分。有些问题可能需要马上处理。

- Robots.txt – 说实话,如果有什么比 robots.txt 文件里的一个小错误更能搅局你的在线流量,我也很想知道。

- Google“site:” 运行指命 – 用这个简单的命令,你可以马上了解你的网站在自然搜索结果中的状态。

- XML 站点地图 – 这玩意儿经常被忽略,但有时候它能揭示很多信息,告诉搜索引擎该怎么看待你的网页。

- Meta Robots 标签 – 如果你对它还一头雾水,那就得查查了,因为它可能在幕后影响着某些页面的自然流量。

- 分析 Google 跟踪代码 – 我们都忙,有时候几天都不查谷歌分析,结果一查吓一跳。

- Search Console 搜索控制台 > 抓取错误 – 最快了解哪些高价值页面需要立即修复的方法。

- Search Console 搜索控制台 > 手动处罚 – 大多数人可能没这问题,但查一查,晚上睡觉也踏实。

- 损坏的内部链接 – 这对用户来说可不是好事,但修起来还算简单 – 绝对值得一查。

- 根域链接 – 用一两个主流工具,快速看看你的回链够不够强,能不能打败竞争对手。

- Ahrefs 或 SEMrush 的数值 – 一个简单的数字,告诉你自然搜索是不是在帮你的忙。

1) Robots.txt – 潜伏的刺客

Robots.txt 看起来人畜无害,但一旦出错,后果可就严重了。

它是个很简单的文本文件,几乎每个网站都有,通常放在 your-domain-name.com/robots.txt 这个位置。

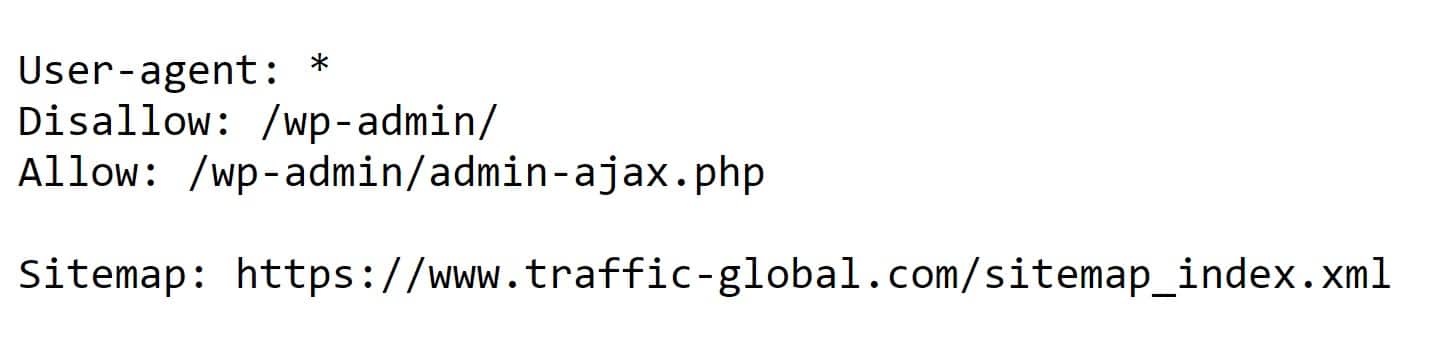

如果设置正确,它应该是这样,以我的为例:

当设置不当时,它会包含 “Disallow: /” 这行字,而不是你上面看到的内容。如果出现这种情况,你实际上是在阻止所有搜索引擎抓取你的网站。这是灾难性的!一定要注意!

行动清单:

去检查你网站的 robots.txt 文件

- 检查文件是否存在。

- 确保文件里没有 “Disallow: /” 这一行——这句话会阻止爬虫访问你网站的全部内容。

- 看看有没有其他被阻止的文件夹

- 看看还有什么其他指示,也可以用 Robots.txt 测试工具来检查,看看会有什么影响,如 TechnicalSEO.com 上的那个工具。

- 额外提示:robots.txt 文件里最好能列出你的XML站点地图或站点地图索引,这样搜索爬虫就有更明确的方向和更多抓取选项了。

进一步阅读

2) Google的 “site:” 搜索运算符 – 了解并验证你的页面数量

你可以通过这个搜索运算符快速检查你的网站页面是否真的被谷歌搜索索引了。如果你有0个页面,那你的站点存在大问题。如果页面数量太多或太少,那也是需要解决的问题。

你只需输入“site:yourdomain.com”,将yourdomain.com替换为你的实际网站域名。

行动清单:

在 Google 搜索中输入 site:yourdomain.com

- 有多少页面? 比你预期的多还是少?

- 你是否看到了奇怪的子域名,比如“dev”或“staging”?

- 你在结果中看到垃圾邮件或黑帽SEO页面了吗?

- 将这个数字与你在Google搜索控制台中看到的进行比较,以验证数据的完整性,并突出显示任何其他缺失的页面。

进一步阅读

3) XML站点地图 – 让Google清晰的索引

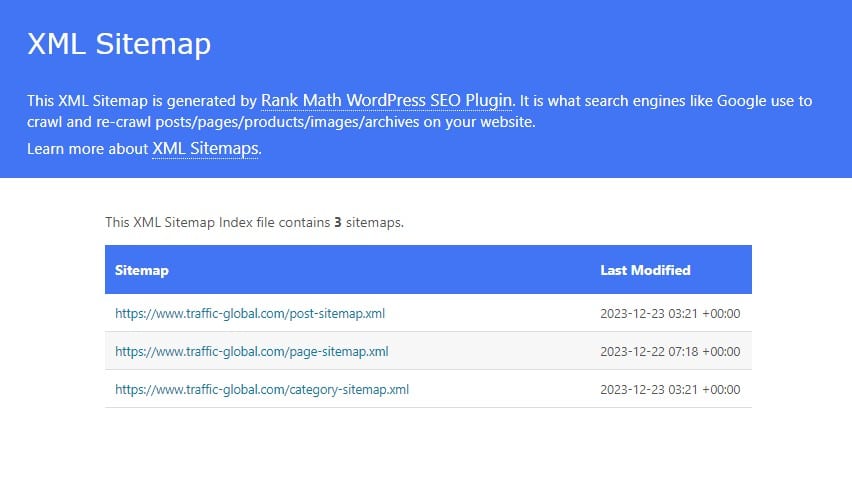

XML站点地图列出了你希望谷歌抓取的网站上所有重要页面,以及它们最后更新的信息。

对于那些拥有优秀外部链接域和良好内部链接的网站来说,XML站点地图可能不是最必要的组成部分。但随着网站变得越来越大且越来越复杂,XML站点地图就变得很有用了。更好的是,如果你有超过50,000个URL,你将需要分成多个站点地图,这时就需要使用站点地图索引了。

即使你不是在管理成千上万的URL,将不同的站点地图分开也是明智的,比如为图片、视频和其他媒体,以及不同类型的帖子和页面分别创建。这样,你可以更好地诊断影响不同子文件夹和目录的问题。

即使你不是在管理成千上万的URL,将不同的站点地图分开也是明智的,比如为图片、视频和其他媒体,以及不同类型的帖子和页面分别创建。这样,你可以更好地诊断影响不同子文件夹和目录的问题。

行动清单:

- 确保你的 XML 站点地图列在 robots.txt 中

- 使用像 Screaming Frog 这样的爬虫来爬行 XML 站点地图,以确保 XML 站点地图中列出的所有页面都不是 404。

- 检查 Google Search Console 的站点地图报告和其中列出的页面索引以及其他错误。

进一步阅读

4) Meta Robots 标签

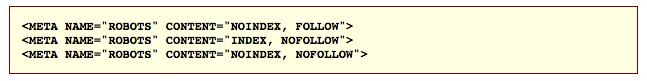

Meta robots 标签非常强大,它可以让你的页面完全不出现在搜索结果中。这并不是好事。使用 meta robots 标签的方法有很多,但最常见的是添加以下命令之一:index、noindex、follow 或 nofollow,像这样:

最常见的情况是,如果你的页面位于用于测试的开发子域上,你可能会对其使用noindex。在你的正式网页上使用noindex是很少见的情况,通常你不会这么做。

默认情况下,如果标签缺失,你的页面将被索引和跟踪。

行动清单:

查看你主页的源代码

- Meta robots标签在吗?

- 如果有,它是显示index, follow 吗?

- 你的网站是否有应该不建立索引的开发版本?

进一步阅读

5) 分析跟踪代码

如果你重新发布了一个网站,然后一两天后你检查你的分析报告,发现流量骤降,你可能会感觉很奇怪,直到你意识到在那段时间里Google跟踪代码只是丢失了。

然而,我们不愿意看到的是,在网站重新设计后,这个标签经常被遗忘。我可以向你保证,你的开发者们并不像你那样频繁地监控 Google Analytics, 所以检查这个需要你自己来做。

有很多工具可以快速测试这一点,我最喜欢的是使用 GA Checker 来快速查看,尽管对于成千上万的页面,你可能需要一个更强大的工具。

行动清单:

查看你主页的源代码

- 在 Google Analytics 中检查您的自然搜索流量趋势

- 使用 GAchecker.com 测试您网站上的所有页面

进一步阅读

6) 搜索控制台抓取错误

如果你想发现网站上的抓取错误,没有比谷歌搜索控制台更好的工具了。在控制台的抓取错误部分,你会找到导致你网站问题的404、软404和服务器错误。

谷歌甚至会根据从你的网站和其他网站指向这些错误的链接数量来优先处理这些错误。

你应该审查并修复最重要的抓取错误。如果你看到大规模问题,你需要找到根本原因。如果你看到个别的404页面,如果它们有外部链接或流量,你应该对它们进行301重定向,但如果它们不重要,你应该让它们保持404状态。

谷歌关于404和SEO的官方说法是:“一般来说,404错误不会损害你网站在搜索中的表现,但你可以使用它们来帮助改善用户体验。”

行动清单:

- 登录 Google Search Console 并检查“抓取错误”选项卡

- 查看 404 错误并修复或重定向最重要的页面

- 查看其他错误类型,例如服务器错误和软 404

进一步阅读

7) Search Console 手动操作

毫无疑问,谷歌的手动惩罚是SEO问题中最严重的一个。这意味着谷歌团队进行了手动操作。检测它很简单,但解决它可能意味着巨大的痛苦。

如果你和你的SEO团队从未进行过黑帽SEO,99%的情况下你是安全的。有极少数情况,负面SEO可能会伤害你,但由于谷歌员工是个别进行手动操作,他们必须非常确定你应该受到手动惩罚。

行动清单:

- 登录 Google Search Console 并检查“搜索流量”>“手动操作”选项卡

- 如果没有任何内容,则会显示“未发现手动网络垃圾邮件操作”。

- 如果确实受到了处罚,你应该立即开始解决问题。

进一步阅读

8) 断开的内部链接

内部链接断裂对网站用户和搜索引擎爬虫都不好。如果用户在你的网站上遇到太多断裂的链接,他们可能会失望并寻找更高质量的网站。

如果你的内部链接断裂,爬虫会被阻止,被引导到404页面。这两种情况都不理想。

如果你的网站足够小,你可以手动测试网站上的链接,这样你可能还会发现一些语法错误。但对我们大多数人来说,这就像拔牙一样痛苦。幸运的是,有很多优秀的工具可以使这个过程变得更容易。

行动清单:

使用以下工具之一来爬取你的网站,寻找内部断裂链接:

- 尖叫青蛙 SEO 蜘蛛 (免费和付费)

- 检查我的链接 或 损坏的链接检查器 Chrome 插件(免费)

- Ahrefs(付费)

- 使用上述工具之一扫描你的网站寻找断裂链接

- 更新或替换断裂链接。如果数量庞大,可以让实习生或外包团队来做。

- 如适用,将旧链接通过301重定向到新页面

进一步阅读

9) 链接根域

有数百个甚至数千个搜索引擎排名因素。然而,链接根域的数量是最重要的之一。

链接根域意味着链接回你网站的不同网站的数量。如果你和你的竞争对手都有 20 个指向各自网站的链接,那么区别在于不同且权威的网站的数量。如果你有来自一个网站的 10 个链接,其余来自 10 个不同的网站,但你的竞争对手有来自 20 个不同网站的 20 个链接,那么他们就会获胜。

你可以使用一些反向链接检查工具快速比较链接根域的数量。你应该尽可能使用多个,以便获得更高的准确性。

行动清单:

使用以下工具之一来检查链接根域(LRD)的数量:

- Moz Open Site Explorer (免费和付费)

- Majestic (免费和付费)

- Ahrefs (付费)

- 使用上述工具之一获取LRD的数量。

- 比较你的网站和竞争对手的数量

- 使用这个信息来逆向工程,为你的链接建设策略找到机会和威胁

进一步阅读

10) Ahrefs 和 SEMrush 的流量成本

你是否想知道你的竞争对手是否通过自然流量赚了很多钱?

当你只想看到流量值多少钱时,没有比使用Ahrefs或SEMrush更好的工具了。你可以快速输入不同的域名,看到它们从搜索结果中获得的大致流量价值。

这两个工具都是通过将每个关键词的搜索量、每次点击成本和排名相乘来得到它们的流量成本值。这个数字并不保证完全准确,但从高层次上让你可以估算一个或多个网站之间的自然流量价值。

你也可以使用其他几个替代工具手动做同样的事情,但如果你寻求速度,这是最佳途径。

行动清单:

- 访问 Ahrefs.com 或 SEMrush.com 并使用付费工具或试用版

- 输入你想要审查的网站,然后使用有机研究标签页获取流量成本数字

- 重复这个过程,针对你的竞争对手,以便轻松比较自然流量收入的实力和机会

进一步阅读

接下来怎么办?

如果你的网站在这10个检查项目上都通过了,那么你就比80%的网站做得更好。

技术SEO对不同的人意味着不同的事情。

根据你正在尝试解决的问题,使用上述资源进一步深入挖掘并为下一个季度优先处理你的问题。

寻找实用的技术SEO咨询?我们可以帮助你。